Mick Sawaguchi

UNAMAS Labelサラウンド寺子屋塾主宰

〜音楽とマルチメディア向けのグラフィカルな統合開発環境(ビジュアルプログラミング言語)maxを使った3D音楽の制作例とインスタレーション設置の実際について3名の講師の方から解説と9chサラウンド・デモを行います〜

講師(発表順)

1981年4月 不二音響株式会社(現 ヤマハサウンドシステム)入社2013年 JVC kenwood Arcsに転籍、現在は、ヒビノアークスへ至る。

1990年京都南座でのスーパー歌舞伎を皮切りに劇場音響サラウンド効果に付いて研究を始め大阪松竹座、博多座、大阪新歌舞伎座、銀座歌舞伎座等の歌舞伎演出音響効果システム、シアターOrbミュージカル音響システム、NHKホールや国立劇場を手掛ける。一方NHK SHV22.2ch リファレンスモニタシステムや22.2ch音声中継車なども手掛け、スーパーハイビジョン民間需要に付いても研究を行う。

最近の設置例としては、2016年11月 マージナルゴング青山スパイラル公演の立体音響効果、InterBEE 2016 Ikegami boothプロジェクションマッピング&立体音響インスタレーションなどのディレクションを行う。

東京藝術大学大学院修了。東京大学工学部研究員を経てアーティスト・プログラマーとして活動する。2016年、ポストヒューマニズムをコンセプト音楽における人間とコンピューターの関係性を捉え直すピアノCDアルバム「Preludes for Piano Book 1」をリリース。近年では東京モーターショーのイベント音楽や日本科学未来館の展示音楽の作曲、六本木ヒルズのクールジャパンオフィスのエントランス照明やスマートイルミネーション横浜の音響・照明作品を手がけ、大学や研究機関のためのプログラムの開発やワークショップを行うなど、音楽やアート作品に留まらない多岐にわたる創作活動を行っている。

今井慎太郎:国立音楽大学 准教授

音や物の微細な運動を剪定し矯正することで創作を行う。国立音楽大学およびフランスのIRCAMで学んだ後、文化庁派遣芸術家在外研修員としてドイツのZKMにて研究活動を、またDAADベルリン客員芸術家としてベルリン工科大学を拠点に創作活動を行う。現在、国立音楽大学准教授。www.shintaroimai.com

期日2017−2月27日(月) 15:00−17:00

会場:mEx—Lounge東京都港区赤坂2-22-21 5F

沢口:

第96回のサラウンド寺子屋塾を始めたいと思います。今回のテーマは、いつものサラウンド制作とは、少し違った切り口のテーマになったと思いますが、きっかけは、2016年11月のInterBEEにて池上通信機70周年記念展示ブースで行われていた会場入り口の3D音楽とCGによる企業イメージコーナーを訪問してこの展示3D音楽を作曲した松本さんを紹介していただいたことに始まります。私自身こうしたプログラムによるインスタレーション3D音楽は、未体験でそれに使用するMaxというプログラミングも初めてでしたので大変新鮮でした。そしてシンタックスの村井さんが、国内ではこの分野の先駆けだということもその時に知りましたので、まず冒頭で、Maxとは何かについて解説していただき、それから3名の方から講演を始めることにしたいと思います。

村井:

みなさんこんにちは。シンタックスJAPANの村井です。

Maxと私の出会いは、1986年以来となります。国内では、故深町純さんが大学へコンピューター音楽学科を創設するというのでこうしたシステムの導入をお手伝いしました。

Maxのオリジナル作成者はミラー・パケット (Miller S. Puckette) であり、1988年にフランスのIRCAM(フランス国立音響音楽研究所)で作曲家がインタラクティブなデスクトップミュージック制作システムにアクセスできるように、ピアノとコンピューターを組み合わせたSogitec 4Xというシステムのためのエディタ・パッチツールとして作られました。

ベル研からスタンフォード大学へ移籍して電子音楽研究室CCRMAを創設したラジオバトンで有名な故マックス・マシューズ博士へのレスペクトとして門下生であるジカレリやパケットがMaxと命名しました。

ベル研からスタンフォード大学へ移籍して電子音楽研究室CCRMAを創設したラジオバトンで有名な故マックス・マシューズ博士へのレスペクトとして門下生であるジカレリやパケットがMaxと命名しました。

1989年、IRCAMはMaxの並行処理版を開発し、NeXTにIRCAM Signal Processing Workstationを接続したもので動作するよう移植しこれを Max/FTS (Faster

Than Sound) と言います。

1989年、MaxはOpcode Systemsにライセンス供与され、同社は1990年にMax/Opcodeという製品でリリースし、現在は、David Zicarelliが1997年に設立したCycling '74によって販売されています。また1990年代にミラー・パケット(Miller Puckette) は、同様なプログラミング言語Pure Data(PD)も開発しました。

Maxにはいくつかの拡張があり1997年に移植された音響拡張セットMSP(Max Signal ProcessingまたはMiller S. Pucketteの略)は、デジタル音声信号をリアルタイムで操作可能となり、ユーザーが独自のシンセサイザーやエフェクトプロセッサを作ることが可能となり同時に映像の制作も取り込むことで様々なアーティストから支持されるようになっています。

沢口:

村井さん、紹介ありがとうございました。Maxの歴史が理解できたところで、最初に平井さんの講演をお願いしたいと思います。先ほど述べました2016年InterBEEでのIkegamiブースでのインスタレーションの実際について紹介していただきます。

再生システムの選定にあたっては、S字の流れの中で3D空間を感じてもらうために横の指向性が広い上下指向性をコントロールされたK-array社のラインアレースピーカを使用し、

TOPレイヤー:外周4CH センター部3CH

ボトムレイヤー:外周4CH センター部3CH

最後に今回の制作プロジェクトを紹介して私の担当を終わりたいと思います。

沢口:

平井さん、どうもありがとうございました。ではこの展示3D音楽をMaxプログラミングにより作成しました。松本さんに講演をお願いしたいと思います。

松本:

みなさん、こんにちは松本です。私の経歴については、冒頭の講師紹介を参照してください。私からは、Maxを使って現在どういった展示作品の制作が可能になっているのか、アート作品と広告の作り方の違いについてアーティストの視点で紹介をします。

「立体生成音楽」という講演タイトルを使っていますが、これはプログラミングによる生成音楽と立体処理を同時に実現させていることを意味しています。このインスタレーションでは開発したプログラムを通じて、尺がある音楽のような1つのオーディオファイルを独自の方法論で解体再構築を行い、無限の尺、マルチタイムラインへと時間軸を解放する仕組みになっており、空間のサラウンドだけでなく時間のサラウンドも実現しています。

最初に平井さんがディレクションしましたIkegamiの展示ブースで再生した14.3CH

3D音楽をここでは、8.1CHで再生しますのでお聞きください。MaxとSPATという空間的音響拡張ライブラリの組み合わせは、再生時のスピーカーCH数や配置レイアウトを柔軟に変更することができるため、同じ作品プログラムを異なる環境に持っていっても最小限の書き換えで済む点も大きな特徴です。Maxでの空間的音響処理の中核となるSPATについては、それだけで単体の独立したソフトのように多機能ですので、私の後に今井さんから詳細な解説をお願いしていますのでそちらを参考にしてください。

デモ再生

このIkegamiでの展示音楽は、Cycling '74 Max7というソフトウェアで制作しており、アート作品としてきちんと新規性ある前衛的なアプローチで音楽の歴史を更新するという私的な挑戦と同時に、広告としてクライアントのイメージを壊さない公的な要求をクリアすることを両立するコンセプトで作曲、プログラム開発をしています。

実際に開発し運用した画面は、以下のようになっています。入力素材として音源ファイルがあり、そこへIRCAM SPATというライブラリを組み合わせて様々な音響処理と空間シミュレーション、音像移動やマルチチャンネル出力が私の設計した作曲、生成プログラムに則りながら、常に変化しつづける終わりが無い楽曲として再生されます。このアプローチをとることで来場者の皆さんは、短時間の鑑賞でも長時間の鑑賞でも同じフレーズを繰り返すことなく、時間帯によっても全てが異なった楽曲表現を楽しむことができます。

このIkegamiでの展示音楽は、Cycling '74 Max7というソフトウェアで制作しており、アート作品としてきちんと新規性ある前衛的なアプローチで音楽の歴史を更新するという私的な挑戦と同時に、広告としてクライアントのイメージを壊さない公的な要求をクリアすることを両立するコンセプトで作曲、プログラム開発をしています。

実際に開発し運用した画面は、以下のようになっています。入力素材として音源ファイルがあり、そこへIRCAM SPATというライブラリを組み合わせて様々な音響処理と空間シミュレーション、音像移動やマルチチャンネル出力が私の設計した作曲、生成プログラムに則りながら、常に変化しつづける終わりが無い楽曲として再生されます。このアプローチをとることで来場者の皆さんは、短時間の鑑賞でも長時間の鑑賞でも同じフレーズを繰り返すことなく、時間帯によっても全てが異なった楽曲表現を楽しむことができます。

このMaxというソフトは音楽ソフトというよりプログラミング環境ツールであり、Ikegamiの展示の際にはアルゴリズム作曲と立体音響化を行うアプリケーションを1からプログラミングし再生しています。システムは、作曲と音響合成、音響処理、スピーカー再生まで一つのプログラムで完結しており最後にオーディオインターフェイスに送られて14.3CHのスピーカーから音が出る仕組みです。

展示音楽やインスタレーションにおけるサウンドは、音楽コンサートと異なり、始まりや終わりは鑑賞者に委ねられます。本展示ではクライアント企業の上昇、絶え間ない進化といったテーマをイメージしたコンピュータープログラムにより、同じ瞬間は二度と訪れない、永遠に終わりが無い音楽がリアルタイムに自動作曲されています。

何分で立ち去っても何時間もその場にいても自由という尺が可変の音楽は、空間を意識的に扱う重要性が増すためメロディー、ハーモニー、リズムといった古典的な音楽の三要素だけではなく立体音響空間での音の三次元的な運動や音色の変化、従来の音楽とは違い複数のタイムラインの混在を主体とする全く新しい作曲法を試みています。

このことで鑑賞者は、自分の立ち位置、頭の向きによっても全く異なる音楽を聴くことが可能になり、正面ステージの音を皆が同じ方向を向き受動的に鑑賞するような従来の音楽から解放され音空間の中に自らが入り込み能動的に音を鑑賞することが可能となります。

今回使用した音の素材は、Ikegamiの歴史や伝統、格式をテーマに音楽史の中心に位置するピアノの音色をメインに据え水中をイメージする泡の音を除くすべての音響は、あらかじめ作曲され録音された私自身のピアノ音楽作品をプログラム内部で時間的にも空間的にも一旦解体し電子音響処理技術を駆使しピアノの音とは思えない音色までリアルタイムに加工してマルチチャンネルスピーカー空間上で再構築し再生しています。

Ikegamiの展示音楽に限らず、少し幅広く立体生成音楽やアートそして広告などの立ち位置について私の考えを紹介したいと思います。多少学術的な側面もありますが、参考にしてください。

アートと 広告の関係

双方が両立するためには、クライアントの意向とアートとしての芸術史における新規性といった項目が重要となります。現代アートではコンセプトを考えること自体が作品そのものといっても過言ではないくらい重要なクリエイティブな行為となっているのに対して、広告の仕事ではアーティスト自身はコンセプトを考えることができません。

双方が両立するためには、クライアントの意向とアートとしての芸術史における新規性といった項目が重要となります。現代アートではコンセプトを考えること自体が作品そのものといっても過言ではないくらい重要なクリエイティブな行為となっているのに対して、広告の仕事ではアーティスト自身はコンセプトを考えることができません。

展示音楽は、特にどこの誰に対しても当てはめることが可能な薄い表現にせず、その展示環境やクライアントの特性でしか成立しないように場の意味や政治的、文化的、歴史的な背景まで考え特化したサイトスペシフィックな作品を作るということが重要であり、概念的な楽譜上、データ上の作曲を完成させるだけでなく、現場に構築した三次元の人工空間をどう使い音響的に展開するか、リアリゼーションの技術の検討が重要になります。

アルゴリズム作曲の要点は、

●

音楽を作曲するための規則(作曲理論)をコンピューター上にプログラミングして構築し、システマティックに音楽を生成するメタ作曲のようなアプローチ

●

楽曲の生成は高速でリアルタイムで行えるため音楽の生成規則自体のデザインを音を聴きながら追い込むことが可能

●

現代の芸術音楽の作曲において最重要である様式をコンピューターを通じて開発しやすい

●

コンピューター以前、古くは中世グイード・ダレッツォの時代から既にシステマティックな作曲法は試みられており、その環境がコンピューターに移行してからは音符だけでなく音色や音像の構築まで飛躍的に可能性は広がった。

●

音色の制御—スペクトルを多重なサイン波の対位法と考えると音色を構成するアルゴリズムを設計することは対位法のアルゴリズムを考えることと近くなる。

●

音像移動—音の運動性をメロディーやリズムのように音楽の要素としてとらえ、作曲と一体化したモチーフとするためにはコンピューターからのアルゴリズミックな制御が欠かせない。

●

作曲からプログラミング、空間処理エンジニアリングまでALL in ONEのスキルを持つことが重要

●

コンピューターベースになることで、持続可能性の問題が生じている。電子音楽作品やメディアアート作品はOSやソフトウエアーが安定的に動作する寿命の問題で10年程度でも展示や再演が困難になることがある。

最後にIkegamiの展示のために製作したプログラムに対して実際に使用した素材とは異なる素材をいくつか突っ込んでみて、ベッヒャーのタイポロジーによる写真作品を音に応用するようなイメージで同一のプログラムから生成される様々なバリエーションを聴いてもらい、それぞれの差異や共通点をから作品そのものの本質を考えてもらうようなデモをしたいと思います。このデモのようなアプローチはたった一つのオーディオファイルを解体しインスタレーション用に時間的、空間的に再構成するプログラムを開発したため実現が可能になっています。

最後にIkegamiの展示のために製作したプログラムに対して実際に使用した素材とは異なる素材をいくつか突っ込んでみて、ベッヒャーのタイポロジーによる写真作品を音に応用するようなイメージで同一のプログラムから生成される様々なバリエーションを聴いてもらい、それぞれの差異や共通点をから作品そのものの本質を考えてもらうようなデモをしたいと思います。このデモのようなアプローチはたった一つのオーディオファイルを解体しインスタレーション用に時間的、空間的に再構成するプログラムを開発したため実現が可能になっています。

これは、ジョン・ケージのIn a Landscapeという楽曲の旋律の構成ルールを分析しピアノ音を素材にしてマルコフ連鎖を利用したアルゴリズム作曲で制作した楽曲の例です。その音源をIKEGAMIの展示音楽用のプログラムにかけると冒頭でデモンストレーションしたようなIKEGAMIの展示空間と同等の音響が生成されます。楽曲の構成自体どの部分がどう組み合わさっても極端な不協和にならないように作曲されているため今回のような広告案件の展示には最適な元素材といえます。

デモ−02 ペロティヌス - Beata Visceraより

まずオリジナル音を再生します。次にこの音源を先ほどと同じプログラムに入れて再生するとこのようになります。

デモ−03 ジャン・フィリップ・ラモー クラブサン曲集より

ハープシコードの演奏です。この特徴的な音色をプログラムにかけるとこのようになります。

デモ−04 アントン・ウエーベルンのop-21より

完全な無調音楽です。これをプログラムにかけるとこのように商業的広告では使えないような暗い響きになります。

今回の生成的インスタレーションのためのプログラム開発では原曲としてのオーディオファイルのイメージを残しながらも即興的に原曲とは異なる私自身の作家性を帯びた音楽のバリエーションがコンピューター上で即興的に展開され持続していくことで新たな表現が開かれていくことを探求しています。

どうもありがとうございました。

どうもありがとうございました。

沢口:

松本さんどうもありがとうございました。私も未知のサラウンド制作分野ですので大変参考になりました。では最後にMaxのプログラムから実際のサウンドとして加工や合成、スピーカーまでの出力といった機能を受け持っているIRCAM-SPATについて国立音楽大学の今井准教授からお願いします。

今井:

2015年にICMC 2015で発表され、クリエイティブ・コモンズby3.0で公開されている、Thibaut Carpentier、Markus Noisternig、Olivier Warusfelによる論文[Twenty Years of Ircam Spat: Looking Back, Looking Forward]に基づいてすすめていきます。なお本論文の日本語訳を以下の私のサイトにアップしていますので、ご興味のある方はぜひご覧ください。

http://shintaroimai.com/spat_j.html

最初に、Spatを活用し、IRCAMで2000年に制作しました私の「青の争い」というチェロとコンピュータのための作品を再生します。

デモ:再生

IRACAM Spatは、入力音をリアルタイムに空間化するツールです。アルゴリズム・リバーブ・エンジンとパンニングのモジュールを核とする、信号処理のライブラリとして提供されています。モジュール式で拡張可能なため、コンサートやミックス、VRなど、様々な使用場面に適合させることができます。また、音響心理学の見地に基づいたインターフェースを備え、求めるルーム・エフェクトを直感的に指定できます。

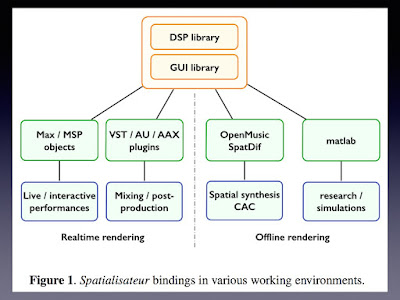

もともとSpatはMax/MSPのパッチでつくられていましたが、徐々にC言語のコードに移植され、2008年から2010年にC++で完全に書き直されました。ソースコードは信号処理とGUIの2つの主要ライブラリに分かれ、またクロス・プラットフォームとなりMax/MSPからも独立しました。このリファクタリングで、より高いパフォーマンス、柔軟なアルゴリズム設定、またDAWへのプラグイン化などが実現しました。そして、様々な使用場面をカバーする複数のバインディングが開発されています。

これから、最も一般的に使われる、Max/MSP上で稼働するSpat~の新しい機能についてご紹介します。

これから、最も一般的に使われる、Max/MSP上で稼働するSpat~の新しい機能についてご紹介します。

リバーブ・エンジン

Spat~は、マルチチャンネルのリバーブ・エンジンを中心に構成されています。リバーブは以下の4つの時間的な分節で成り立っています。

●

OD:直接音

●

R1:初期反射音

●

R2:後期反射音(クラスタ)

Spat~のバージョン4では、リバーブテイルを合成するFDN(Feedback Delay Network)が改良され、より高密度でリアルな残響音をつくれるようになりました。

以下にSpat~の全体の信号処理チェーンを示します。入力部はフィルタやドップラー効果など、音源の事前処理をします。ルームと呼ぶリバーブ・エンジン部で合成されたリバーブは、時間分節ごとにパンニング部で処理されます。最後に出力部で、再生システムに従って音声信号をデコードもしくはトランスコードします。スピーカのEQやディレイ、ゲイン調整も行います。

Spat~でパンニング処理するspat.pan~オブジェクトは、任意の入出力チャンネル数と空間化アルゴリズムを設定できます。伝統的なA-Bステレオからバイノーラル、VBAPなどのアンプリチュード・パンニングまでを広範にサポートしています。

近年のSpat~では、2000年以降に進展した高次アンビソニックス(HOA)に対応しました。spat.pan~オブジェクトは、あらゆる次数での2Dと3DでHOAのエンコーディングができます。spat.hoatransform~オブジェクトは、音像を曖昧にする空間ブラー効果をつくったり、3D音場を効率的に回転させたりすることが可能です。spat.decoder~オブジェクトはHOAのデコーディングを行います。スピーカの配置がまばらでも仮想音源の大きさを保持する、エネルギー保存デコーダが実装されています。そのほかにもアンビソニックスを扱うためのユーティリティが開発されています。

以下の図が、Spat~上のHOAワークフローです。この例では、3つの音源を2D3次アンビソニックスにエンコードし、7つのスピーカに対してデコードしています。

また、5.1chのミキシングに特化したTransPanという新しいツールが開発されました。複数の空間化レイヤを組み合わせることで、5.1ch規格の弱点である側面の音源の精度を向上させます。また仰角に仮想音源をつくることもできます。

次に、直感的なパラメータ・コントロールの中核となるGUIについて紹介します。

ユーザ・インターフェース

spat.viewerは、音源とスピーカの位置や方向を視覚化し、編集するためのツールです。マウス操作だけでなく、Max/MSPのメッセージでも操作できます。また、Spat~の音声処理エンジンには結びつけられていないので、他の空間化プログラムを操作するためにも使うことができます。

spat.operは、リバーブの音響特性について、部屋のサイズやリバーブの長さだけでなく、重厚感や包まれ感といった知覚軸に沿って設定ができます。異なる設定間を補間処理することもできます。さらに音源の放射角度や指向性、距離減衰などの様々なオプションが用意されています。

そのほか、音の空間化やモニタリング、オーサリングのために、様々なユーザー・インターフェースが開発されています。以下に概要を示します。

室内インパルス応答

コンピュータの処理能力の向上により、コンボリューション・ベースのリバーブが多く使われるようになったため、そのための新しいオブジェクトが追加されました。高効率のコンボリューション・エンジンや、IR測定や解析のためのツールも用意されています。

spat.hybrid~オブジェクトは、リアルなコンヴォリューション・リバーブの初期反射と、より自由度の高いFDNを組み合わせた、新しいアプローチのリバーブ・エンジンです。これもspat.operによる知覚軸に沿った操作が可能です。

Spat~ではこの他にも、一般的な用途にも使えるマルチチャンネル・ツールや、オーディオエフェクトを備えています。また、HRTFなどの空間音響データを保存するための、SOFA(Spatially Oriented Format for Acoustics)フォーマットをサポートしています。

それでは最後に、ドラムのサンプル音源を使用して、実際にIRCAM Spatでリアルタイムに空間化してみたいと思います。お聞きください。

デモ:ドラムサンプルで響きや定位、距離感、音像の制御などをデモ

どうもありがとうございました。

SPATは、クロス・プラットフォームということですがMaxと似たPure Dataプログラミングでも反映できるのですか?

A:残念ながらPDには対応していません。

Q-02

展示音楽はバイノーラル化も行ったとのことですが、実際のIkegamiの会場では、どうしたのですか?

A:会場の三次元でのシミュレーションは現場に行かなければ伝わらないものであるため、クライアントに対してはSPATでバイノーラル化した2chアウトをヘッドフォンで確認してもらいましたが、それが本質ではないため鑑賞者は会場で本物3Dの音を聴いてもらっています。

Q-03

リアルタイム処理ができるのがSPATの特徴と理解しましたが、その応用範囲は、演劇や舞台、コンサートLIVEなどでも信号を受け付けて操作できるということですか?

A:そうです。受け渡しの信号形式も選択肢が多いのでそうしたジャンルでも応用できます。

過去に愛知トリエンナーレにて藤本隆行、白井剛のコンテンポラリーダンス作品『Node/砂漠の老人』でもバイオリニスト辺見康孝の音を処理するなどで使用してきました。コンサートでも当然応用可能ですが、PAもMaxプログラマーだったりそれなりにサウンドプログラミングへの理解があって実現したものであり、従来のエンジニアでは空間へのアプローチが違うため齟齬が生じやすく実現が難しいです。立体音響のエンジニアに関しては人材が不足しており、アーティストが片手間でやることも少なくない状況があり、エンジニアの育成が急務だと感じています。